EC3 ofrece una primera valoración de urgencia del nuevo producto de Google, Scholar Metrics. En los próximos días publicaremos más análisis sobre diversos aspectos de esta nueva herramienta bibliométrica.

--------------

UPDATE: Download the English version of our paper!

-------------

Cabezas-Clavijo,

Álvaro; Delgado-López-Cózar,

Emilio (2012). “Scholar Metrics: el impacto de las revistas según Google, ¿un divertimento o un producto científico

aceptable?”. EC3 Working Papers, 1, 9 de abril. Disponible en http://hdl.handle.net/10760/16830

INTRODUCCIÓN

Google sorprendía el pasado 1 de

abril con el lanzamiento de Google Scholar Metrics, un nuevo producto que

ofrece un índice de impacto de las revistas científicas, medido a partir de

recuentos de citas. La fecha no pasó inadvertida para la comunidad

investigadora en las redes sociales que se preguntaba si era un producto real o

una broma (el 1 de abril es el April Fools' Day, equivalente al Día de los

Inocentes español). Sin embargo, para solaz de bibliómetras e intranquilidad de

algunas multinacionales de la edición científica, el producto de Google no era

una broma, sino un paso natural de Google dentro de la expansión de la familia

Scholar.

Este movimiento no por esperado

deja de ser relevante. Tras algún tiempo calibrándose la utilidad de Google Scholar como herramienta para la evaluación científica (Torres-Salinas, Ruiz-Pérez y Delgado-López-Cózar, 2009), Google se adentra ahora en el mismísimo santo y seña de la

bibliometría: los índices de impacto de las revistas. El lanzamiento hace

escasos meses de Google Scholar Citations (Cabezas-Clavijo y Torres-Salinas,

2012), herramienta de medición del impacto de los investigadores, suponía un

aviso de los planes de Google en el mundo de la información y evaluación científica.

La puesta en marcha ahora de la clasificación de revistas en función de su

índice h entra en competencia directa con los diferentes productos e índices de

revistas existentes en el mercado, y muy particularmente con los Journal

Citation Reports (JCR), el estándar para la medición del impacto de las

revistas.

En esta nota urgente repasamos las características más significativas de Google

Scholar Metrics, señalando sus fortalezas y debilidades (siempre teniendo en cuenta que los productos

de Google van incorporando progresivamente nuevas funcionalidades), y se

discuten las posibilidades de adopción para la evaluación de revistas.

DESCRIPCIÓN

Scholar Metrics ofrece en su

primera versión una clasificación de las primeras cien revistas del mundo por

idioma de publicación. La ordenación de estas listas se basa en el índice h de

las revistas, calculado a partir de los artículos publicados en los últimos cinco

años (2007-2011). Esto es, una revista con un índice h de 12 (por ejemplo, El

Profesional de la Información) significa que ha publicado 12 trabajos con al

menos 12 citas cada uno de ellos. Como dato adicional se ofrece asimismo la

mediana del número de citas obtenida por los artículos que contribuyen al

índice h. Lógicamente, el valor de la mediana nunca puede ser inferior al valor

del índice h de la revista. Scholar Metrics usa este indicador (h5-median) para

ordenar las revistas con el mismo valor de h-index, algo necesario dado que, al

tomar valores discretos, este indicador tiene escaso poder discriminatorio.

Asimismo se pueden consultar los artículos que contribuyen al índice h de cada

revista.

Figura 1: Página de inicio de Google Scholar Metrics con las publicaciones con mayor índice h.

La consulta de Scholar Metrics se

puede realizar de dos formas distintas:

- Accediendo a los listados por idiomas (diez en la actualidad: inglés, chino, portugués, alemán, español, francés, coreano, japonés, holandés e italiano). Se muestra por cada idioma un ranking de las 100 revistas con mayor índice h.

- Haciendo uso del buscador para buscar por palabras incluidas en los títulos de las revistas. En este caso, solo ofrece 20 resultados.

Figura 2: Las 20 publicaciones con mayor índice h con el término "Library" en el título.

A este respecto hay que señalar que las revistas incluidas en este producto no son todas las indizadas en Google Scholar, sino que se ha hecho una selección, en base a dos criterios: solo se incluyen revistas que hayan publicado al menos 100 artículos en el periodo 2007-2011 y que hayan recibido alguna cita (esto es, se excluyen las revistas con índice h=0).

Conviene advertir que los índices de las revistas son los alcanzados por las mismas a fecha 1 de abril de 2012. No se trata, por tanto, de un sistema de información dinámico pues no se actualiza a medida que las revistas van recibiendo más citas sino que queda fijo con los datos a dicha fecha. Aunque no se anuncia, es de esperar que periódicamente Google actualice dichos listados.

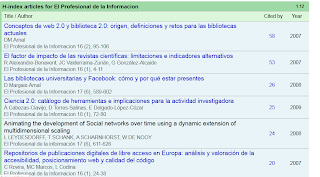

Figura 3: Listado de algunos de los artículos que contribuyen al índice h de la revista El Profesional de la Información.

LIMITACIONES

Una revisión de las

prestaciones de Google Metrics junto a una primera observación de los listados de

revistas ofrecidos ya apunta alguna de

las principales limitaciones del producto.

- Cobertura. Resulta francamente sorprendente la ambigua por no decir confusa definición de cuáles son los documentos objeto de medición de Google Metrics. Aunque a lo largo de la escueta nota metodológica que acompaña al producto las referencias explicitas a las revistas científicas son constantes (“…If you can't find the journal you're looking for…”, “If you're wondering why your Journal…”), se declara que se incluyen artículos de revistas procedentes de las webs que cumplen los criterios de inclusión de Google así como “actas de congresos” y preprints de “algunas fuentes seleccionadas manualmente”. Hay que esperar a ver los listados ofrecidos o realizar algunas consultas bibliográficas para encontrarse con la gran sorpresa: la indiscriminada mezcla de fuentes documentales tan distintas como las revistas, repositorios (RePEc, Arxiv y Social Science Research Network), bases de datos (Cochrane database of systematic reviews), actas de congreso (IEEE Conference on Computer Vision and Pattern Recognition, CVPR; Proceedings of the ESSCIRC; Proceedings of SPIE; AIP Conference Proceedings) y working papers (Nber Working Paper Series). ¿Es que acaso los responsables de Google Metrics desconocen las diferente naturaleza de estos productos que impide su comparación bibliométrica? Así no es de extrañar que de las diez publicaciones con mayor índice h en inglés, tres sean repositorios (RePEc, Arxiv y Social Science Research Network), probablemente algunas de esas “fuentes seleccionadas manualmente”. La pregunta es evidente: ¿por qué se seleccionan estos y no otros? Meritorios repositorios como Dialnet o E-LIS, aunque tengan distintos propósitos y coberturas, podrían aparecer perfectamente en los listados. En fin, esta decisión es sorprendente y desde luego, no está justificada, máxime cuando la inclusión se ha limitado a una serie de fuentes de información y no al conjunto de actas de congresos, bases de datos o repositorios de materiales de investigación.

- Control de fuentes: A las ya clásicas erratas detectadas por Peter Jacsó (2008) en Google Scholar, que encontró a tan prolíficos autores como Password, Building, Introduction o View cabría añadir en Google Metrics la no tan productiva revista pero de tan simpar rareza como “Age (years)” incluida en el listado de revistas en español en el puesto 99.

- Falta de normalización. Confeccionar un índice de impacto de revistas exige un laborioso a la par que enojoso trabajo de normalización de los títulos de revista. Esto es el abc en bibliometría. Es por lo que resulta impropio que Google, reconociendo el problema pues afirman que han encontrado hasta 959 formas de nombrar a la revista PNAS (Proceedings of the National Academy of Sciences) cometa errores tan infantiles como el de la Revista Española de Cardiologia que aparece con dos entradas distintas (una con ñ con un h de 24 y otra sin ñ con un h de 19). Más inadmisible resulta que Google haya prestado tan poco cuidado a la presentación formal del producto cuando ni siquiera se ha molestado en mostrar uniformemente los títulos de las revistas: unos aparecen –los más- con su denominación completa, otros con la abreviada (Nutr Hosp, Rev Argent Cardiol, Rev. CEFAC, Rev. bras. Enferm…); algunos títulos figuran en mayúscula (REVISTA DE SALUD PÚBLICA, BOLETÍN GEOLÓGICO Y MINERO, REVISTA BRASILEIRA DE OTORRINOLARINGOLOGIA…) frente a la mayoría que se presentan en redonda. En fin, pequeños detalles que no hubiera costado mucho subsanar dado que en los listados solo se visualizan 1200 revistas.

- Consulta de resultados. Pero la principal crítica no se dirige a estos aspectos, sino que versa sobre la manera en que Google ha dispuesto la consulta de los datos. La posibilidad de consulta únicamente por idiomas es desde luego inédita en bibliometría, y tiene poco valor práctico. Lo lógico sería disponer los datos para su consulta por áreas o disciplinas científicas, dado que los indicadores bibliométricos como el índice h son enormemente dependientes de los patrones de producción y citación de cada área científica y no son comparables entre disciplinas. De esta manera la única forma de consultar las revistas con impacto en un área determinada es buscarlas una a una, y sin la certeza de si están o no incluidas, ya que no se ofrece en ninguna parte un directorio con las fuentes de información recogidas por Scholar Metrics.

UNAS REFLEXIONES FINALES

Señaladas estas limitaciones, hay

que valorar positivamente este paso adelante de Google, que va a

facilitar la consulta del impacto de las revistas por parte de muchos

investigadores que no tienen acceso a las tradicionales bases de datos de

citas, lo que puede estimular la competencia entre los diferentes productos.

Asimismo la popularidad del índice h para evaluar investigadores, y su

facilidad para el cálculo y comparación pueden hacer arraigar esta medida,

también para la evaluación de revistas, muy especialmente en Humanidades, área

que cuenta con pocos indicadores bibliométricos de impacto de las revistas.

Desde el punto de vista de la

evaluación científica, ya es incuestionable que Google Scholar se adentra en

este nicho de mercado y que trabaja en productos que son competencia directa de

Thomson Reuters y de Elsevier. De la medida en que Scholar Metrics solvente

algunas de las limitaciones referidas y se integre con los perfiles personales de Google Scholar Citations y con los resultados de la búsqueda clásica en

Google Scholar dependerá muy probablemente su éxito entre los científicos y su

utilidad para la comunidad evaluadora.

De momento hay que ser muy críticos: es decepcionante ver como Google, un imperio económico fastuoso que maneja unos recursos impresionantes, presenta un producto de tan cortos vuelos y de tan mala ejecución desde el punto de vista bibliométrico. Google debe ser consciente de que hacer productos bibliométricos serios exige algún esfuerzo y algunos medios más que poner en danza un algoritmo y un robot que produzcan automáticamente resultados. Da la impresión que para Google, la evaluación científica con herramientas bibliométricas es un campo para “jugar” y no para retar científicamente a la competencia y mejorar la cuenta de resultados.

De momento hay que ser muy críticos: es decepcionante ver como Google, un imperio económico fastuoso que maneja unos recursos impresionantes, presenta un producto de tan cortos vuelos y de tan mala ejecución desde el punto de vista bibliométrico. Google debe ser consciente de que hacer productos bibliométricos serios exige algún esfuerzo y algunos medios más que poner en danza un algoritmo y un robot que produzcan automáticamente resultados. Da la impresión que para Google, la evaluación científica con herramientas bibliométricas es un campo para “jugar” y no para retar científicamente a la competencia y mejorar la cuenta de resultados.

Por último, conviene no olvidar que

este producto llega en un momento de creciente debate entre la comunidad

investigadora en dos frentes, diferentes pero relacionados. Por un lado, está

aún candente el debate acerca de las leyes de acceso a la información

científica como la Research Works Act estadounidense (Ley de Trabajos de Investigación),

apoyada en principio por multinacionales como Elsevier y que retiró su apoyo a dicha ley tras el boicot a sus revistas auspiciado por un grupo de científicos,

y que ha conseguido reverdecer el movimiento open access. Por otro lado, dentro

de la comunidad evaluadora también existe una tendencia encaminada a la

búsqueda de nuevos indicadores de impacto y visibilidad de la producción

científica, dentro de las iniciativas conocidas como alt-metrics o métricas alternativas. Probablemente también en la medida en que Google sepa despertarse

las simpatías de ambos movimientos aumentará su posición de fuerza en la

comunidad académica. Pero sin duda lo que depertará las simpatías de los

gestores de las políticas científicas es la gratuidad de los productos de la

compañía de Silicon Valley en comparación con los costes de las bases de datos

de Thomson Reuters y de Elsevier.

-------

Éstas son unas primeras valoraciones de urgencia de Google

Scholar Metrics. En próximos días ofreceremos un análisis más detallado del

producto y de las consecuencias que se derivan para la evaluación investigadora.

REFERENCIAS

Cabezas-Clavijo, Á. & Torres-Salinas, D. (2012). “Google Scholar Citations y la emergencia de nuevos actores en la evaluación de la investigación”. Anuario ThinkEPI, 6. http://ec3noticias.blogspot.com.es/2011/12/thinkepi-google-scholar-citations-y-la.html

Jacso, P. (2008). “The pros and cons of computing the h-index using Google Scholar”. Online Information Review 32(3), 437-452. http://www.jacso.info/PDFs/jacso-GS-for-h-index-unabridged.pdf

Torres-Salinas, D., Ruiz-Pérez, R. & Delgado-López-Cózar, E. (2009). "Google Scholar como herramienta para la evaluación científica". El profesional de la Información, 18(5), 501-510. http://ec3.ugr.es/publicaciones/d700h04j123154rr.pdf

3 comentarios:

Hola,

Una consulta (creo) sencilla para comprender mejor la metodología este nuevo ranking métrico: ¿qué es y de dónde procede una cita en el contexto de Google Scholar?. CiteSeer procesa las referencias bibliográficas de los documentos científicos que indexa, ¿qué hace GS?. Por ejemplo, si esta nota del blog referenciara un trabajo mío, ¿yo recibiría una cita?. Es decir, qué considera GS por referencias bibliográficas, digamos "útiles", para luego computar las citas recibidas. Además, ¿tiene alguna importancia el formato del archivo html, pdf, doc, etc.?

Saludos y gracias,

Cristian

Hola Cristian,

aunque no hay un listado concreto de las fuentes que indiza Google Scholar, se supone que toma los datos de sitios webs académicos, de repositorios y de las webs de las editoriales científicas, básicamente.

Siguiendo tu ejemplo, una cita desde aquí a un trabajo tuyo no se computaría en GS, ya que Blogger no es indizado por GS. Si fuera al revés, esto es, tu paper depositado en un repositorio por ejemplo citara esta entrada en el blog, esa cita sí sería registrada por GS.

GS recomienda formatos y estructura de los documentos para su correcta indización. Toda la info al respecto la puedes encontrar en http://scholar.google.es/intl/es/scholar/about.html

Saludos

Gracias Alvaro.

He aquí una nueva caja negra. Conocemos algo de lo que ingresa (ciertas fuentes), desconocemos las pautas y el mecanismo de procesamiento, y obtenemos un resultado que no sabemos muy bien como se generó (cómputo de citas).

Saludos,

Cristian

Publicar un comentario