Álvaro Cabezas

Clavijo y Daniel Torres-Salinas

El lanzamiento

hace escasos meses de Google Scholar Citations [1], la herramienta para medir

el impacto de los investigadores en las publicaciones indizadas por el popular

buscador, nos da pie a revisar ésta y otras aplicaciones de índole bibliométrica

encaminadas a medir la visibilidad de académicos e investigadores en la web.

Este impacto no sólo se limita a los medios tradicionales (citas recibidas

desde otros trabajos científicos) sino que abarca a las nuevas vías de

comunicación científica y a sus indicadores asociados, como el número de descargas

de un trabajo, las personas que lo almacenan

en su gestor de referencias o las veces que una presentación es visionada online.

Asimismo se discute brevemente en qué medida puede afectar la emergencia de

estas nuevas herramientas a las bases de datos tradicionales para la evaluación

de la ciencia, Thomson Reuters-Web of Science [2], y Scopus-Elsevier [3].

La joven estrella: Google Scholar Citations.

Google

Scholar Citations fue oficialmente lanzado en pruebas en julio de 2011,

generando de inmediato un importante eco en la web. Su propuesta es muy

sencilla, recopila la producción científica de un investigador y la muestra

agregada en una página personal, con información del número de citas de cada

ítem. El investigador, una vez dado de alta, puede editar los registros de

Google Scholar, corrigiendo (normalizando) la información del buscador, unir

registros duplicados, e incluso añadir de forma manual otros trabajos que hayan

escapado a las garras de Google. Además presenta tres indicadores bibliométricos;

el número total de citas de los trabajos, el índice h del investigador, y el

índice i10, esto es el número de trabajos con más de diez citas, tanto para

toda la carrera académica como para el periodo más reciente. En este apartado

hay que mencionar que Google ha prescindido de la métrica más sencilla: el

número total de trabajos de un investigador; así como de otras medidas como el

promedio de citas por trabajo, o indicadores relativos al impacto de las

revistas. Pero quizá lo más interesante es que la información sobre las citas

recibidas y la producción se actualizan de forma automática a medida que va

siendo indexada por Google, sin necesidad de concurso por parte del académico,

que encuentra siempre su información al día. Las posibilidades que abre este

producto son enormes, tanto en la medición del impacto personal como de cara a la

visibilidad del investigador en la web.

Figura 1: Página personal en Google Scholar Citations

En cuanto

a lo primero, y pese a que no es aconsejable el uso de Google Scholar como herramienta

para la evaluación científica [4] cada vez es más usado especialmente en áreas

de Ciencias Sociales y Humanidades como medio para recuperar las citas de un

trabajo, datos tenidos muy en cuenta tanto en los procesos de solicitud de

sexenios de investigación como en las acreditaciones a los cuerpos docentes

universitarios. Respecto a la visibilidad académica, el investigador se vincula

a las materias en las que es especialista, de manera que se va generando un

directorio temático de expertos, ordenados en función del número total de citas

de sus trabajos. Además de esta función para localizar expertos en un área

determinada, los perfiles de los investigadores dados de alta aparecen

integrados en los resultados de las búsquedas por autores, por lo que se puede

acceder de forma rápida a toda la producción científica de un investigador. Sin

embargo, algunos autores como la creadora del software Publish or Perish [5]

Anne-Wil Harzing expresan sus temores acerca de la honestidad de los autores, y

si estos no serán capaces de falsear sus datos en busca de un ascenso académico

o como manera de aumentar su visibilidad en la web [6].

Desde noviembre

de 2011 el servicio está abierto a todos los investigadores, y en los primeros

días de libre acceso al producto comienzan a verse ya un buen número de

profesores y profesionales de la Documentación, muchos de ellos españoles [7].

Sin embargo cabe preguntarse si llegará a ser significativo el número de los

que se creen su perfil, requisito indispensable para aparecer en estos

directorios. Otra duda acerca del producto es la manera de ordenar a los

investigadores en el directorio por materias. Actualmente esta ordenación se

hace en función del número total de

citas, una clasificación demasiado tosca ya que favorece a los investigadores

de disciplinas grandes, así como a los de mayor recorrido y con mayor número de

trabajos publicados. De facto, Google Scholar Citations está estableciendo

rankings de investigadores por materias en función de un único criterio (fácilmente

manipulable, además), lo cual es un arma de doble filo. Como señalaba Harzing

cualquiera puede falsear sus datos para aparecer en posiciones prominentes, sin

embargo parece poco probable ya que sería rápidamente detectado por el resto de

usuarios, cayendo en el descrédito científico. Otra duda que nos asalta es si

los investigadores con escaso impacto académico crearán su perfil, ya que

podrían quedar en evidencia respecto a otros compañeros de disciplina o de departamento,

con currículos mucho más lucidos. Al final, se corre el riesgo de crear un

directorio de científicos altamente

citados, que no sea representativo de la investigación que se da en un

campo. Pese a la juventud del producto, ya surgen los primeros análisis en

algunos blogs, como el que realiza Brian Kelly de las más destacadas

universidades británicas [8], o el del bibliotecario holandés Wouter Gerritsma,

que presagia que en cinco años Google habrá cambiado completamente el mercado

de las bases de datos científicas [9].

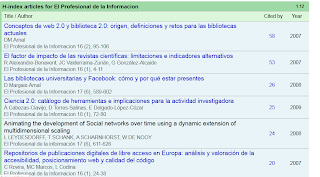

Figura 2: Directorio de investigadores registrados en la materia "Information Science"

El actor secundario: Microsoft Academic Search.

Este

producto de Google viene precedido por los movimientos que otros de los

gigantes de la web, Microsoft ha venido realizando en los últimos meses con su

buscador Microsoft Academic Search [10]. Este producto, heredero de Windows

Live Academic y de Live Search Academic, surgió en su actual denominación en 2009,

sólo para el campo de la Informática, pero

cubre desde septiembre de 2011 todos los ámbitos del conocimiento. También

permite la creación de perfiles personales a partir de la información recogida

por el buscador, proporcionando hasta el momento más indicadores y

funcionalidades de las que ofrece Google. Asimismo admite la edición y

modificación de registros, subir pdfs con el texto completo de los trabajos,

insertar el listado de publicaciones en otra página web, o incluso ver el

contexto en el que un trabajo ha sido citado, un viejo sueño de la bibliometría

evaluativa. Además el producto de Microsoft no se ciñe a la escala personal

sino que permite seguir la pista a la producción científica de una institución

e incluso efectuar comparaciones entre ellas, tomando los parámetros habituales

de producción y citas como términos de la ecuación. Otra de sus fortalezas es

la posibilidad de explorar la red de colaboraciones de un investigador, así

como las relaciones a través de las citas. Además, se pueden encontrar los

perfiles de cualquier investigador, no sólo de los registrados, ya que esto no

es imprescindible.

Sin

embargo, en comparación con Google Scholar Citations, el proceso de actualización

del cv es más pesado, tarda unos días ya que debe ser revisado por el equipo

del producto, y además la cobertura parece bastante menor que la de Google, si

bien no disponemos de un listado de las fuentes que cubre ninguno de los dos

productos. En este pequeño estudio de la producción de siete investigadores

británicos [11] se observa la gran diferencia entre los resultados que ofrece

Academic Search y los que arroja Google Scholar Citations [11]. Además se

aprecian importantes problemas de normalización, una de las críticas

principales que también cabe hacer a Google.

Figura 3: Página Personal en MS Academic Search

En cuanto

a aplicaciones que permiten la confección de currículos vitae personales,

también es necesario reseñar ResercherID [12], producto impulsado por Thomson

Reuters que trabaja únicamente sobre la información recogida en la Web of

Science. Al contrario que Google Scholar Citations o MS Academic Search, la actualización

de la producción no es automática, es decir cada vez que un nuevo artículo nuestro

sea recogido en Web of Science, deberemos actualizar manualmente nuestro perfil

en ResearcherID. Herramientas como la red social científica ResearchGate [13] o

el gestor de referencias Mendeley [14] también proporcionan espacio para que el

investigador incluya sus publicaciones en una página personal.

Los actores alternativos: las iniciativas alt-metrics.

Aprovechando

las diferentes aplicaciones para investigadores surgidas en los últimos años en

el entorno de la ciencia 2.0 [15] son varias las iniciativas dirigidas a medir

el impacto de los materiales publicados on-line, de forma más amplia que con el

recuento de citas. Dentro de estas iniciativas conocidas genéricamente como

alt-metrics o métricas alternativas [16] han aparecido aplicaciones como

ScienceCard [17], un metaproducto que

hace uso de apis externas para ofrecer para cada investigador además de su producción

indizada en MS Academic Search, o el número de citas según Scopus, las veces

que un trabajo ha sido marcado como favorito en citeulike [18], o las personas

que lo han alacenado en el gestor de referencias bibliográficas Mendeley. La

idea que subyace es que hay múltiples maneras de medir la influencia de los

investigadores en la web y que el número

de citas es sólo una de ellas. Otra iniciativa reciente es Total Impact [19]

donde, en la misma línea, podemos descubrir métricas de las presentaciones

colgadas en Slideshare [20], las veces que se ha compartido un artículo

científico en Facebook [21], o el número de grupos en Mendeley donde se ha

recopilado un determinado trabajo. Estas iniciativas siguen el camino trazado

por las estadísticas a nivel de artículo [22] implementadas por la editorial Public Library

of Science (PLoS) que lleva tiempo ofreciendo, además de las citas que un

artículo atrae, datos sobre el número de descargas de un trabajo, el número de

comentarios que genera o el número de blogs que lo enlazan [23].

Figura 4: Estadísticas de impacto de investigador en Total Impact

Los actores consolidados: ISI Web of Science y Scopus.

En este

sentido hay que mencionar que los

actores tradicionales en el campo de la evaluación de la ciencia no se

han quedado de brazos cruzados. Thomson Reuters, además de incrementar en los

últimos años considerablemente su cobertura de revistas científicas de alcance

regional, acaba de lanzar el Book Citation Index [24], su índice de citas con

información de libros, dirigido principalmente a las Humanidades y las Ciencias

Sociales, áreas donde estos vehículos de difusión juegan un papel importante.

Por su parte, Scopus ha incorporado las métricas SNIP y SJR [25] a su base de

datos para ayudar a los bibliómetras. Además ha sacado al mercado aplicaciones

(apps) para dispositivos móviles [26] y ofrece asimismo conexiones con su base

de datos mediante apis [27], que permite mostrar por ejemplo en repositorios

institucionales el número de citas cosechadas por los trabajos recogidos en la

fuente de datos de Elsevier.

Consideración final

Desde el

plano de la política universitaria y de evaluación de la investigación, la

pregunta que cabe realizarse es si alguno de los productos mencionados tanto de

Microsoft y de Google principalmente pero también de las iniciativas

alt-metrics pueden ser serios competidores en un futuro próximo para las dos

grandes bases de datos que proporcionan información bibliométrica, de

importante coste económico, especialmente en una época marcada por los recortes

presupuestarios. Los productos tradicionales son más solventes y estables que

los nuevos, ofreciendo un amplio abanico de posibilidades y de métricas

asociadas, no sólo a los trabajos sino también a las revistas en que éstos se

publican. Además su uso está extendido y existen unas métricas validadas por

los profesionales de la bibliometría así como por parte de las agencias con

responsabilidad en materia investigadora. Sin embargo es legítimo el debate

acerca de si dichas bases de datos son imprescindibles en los procesos de

evaluación investigadora. En nuestra opinión, en la actualidad estas bases de

datos (ISI Web of Science o Scopus, no son necesarias las dos) son

imprescindibles para la evaluación, sin embargo la nueva generación de Sistemas

de Información Científica (CRIS) [28] junto a buscadores científicos de acceso

gratuito como Google Scholar, y las métricas basadas en el uso de la

información pueden aportar nuevas soluciones a la evaluación de la ciencia, haciendo

a medio plazo quizá menos necesarios los costosos índices de citas. Haciendo prospectiva-ficción cabría pensar cómo

cambiaría el mercado de la información y evaluación científica si Google

decidiera lanzar su propio “índice de impacto” a partir de la información que indiza,

lo cual no parece descabellado ya que su popular sistema de ordenación de

búsqueda PageRank se basa en un principio que ya aplican otros índices bibliométricos.

En cualquier caso lo que es indudable es que los nuevos productos y

herramientas a disposición de investigadores y evaluadores facilitan tanto la

difusión como la recuperación de información científica y abren nuevas

posibilidades para el intercambio de la información científica y su evaluación.

Notas